A16Z montó un servidor con 8 RTX 4090, 10G simétrico y 0 dependencia de la nube. Lo llaman DeepSync

Andreessen Horowitz (a16z) dio un paso audaz en infraestructura de IA al diseñar y montar un servidor GPU completamente on-premises, equipado con ocho tarjetas NVIDIA GeForce RTX 4090, conectividad de red simétrica de 10 Gb/s y cero dependencia de proveedores de nube pública. Esta iniciativa, liderada por Marco Mascorro y el equipo de Infraestructura de a16z, demuestra que es posible lograr un rendimiento comparable al de centros de datos tradicionales, manteniendo un control total sobre los datos y los costos operativos.

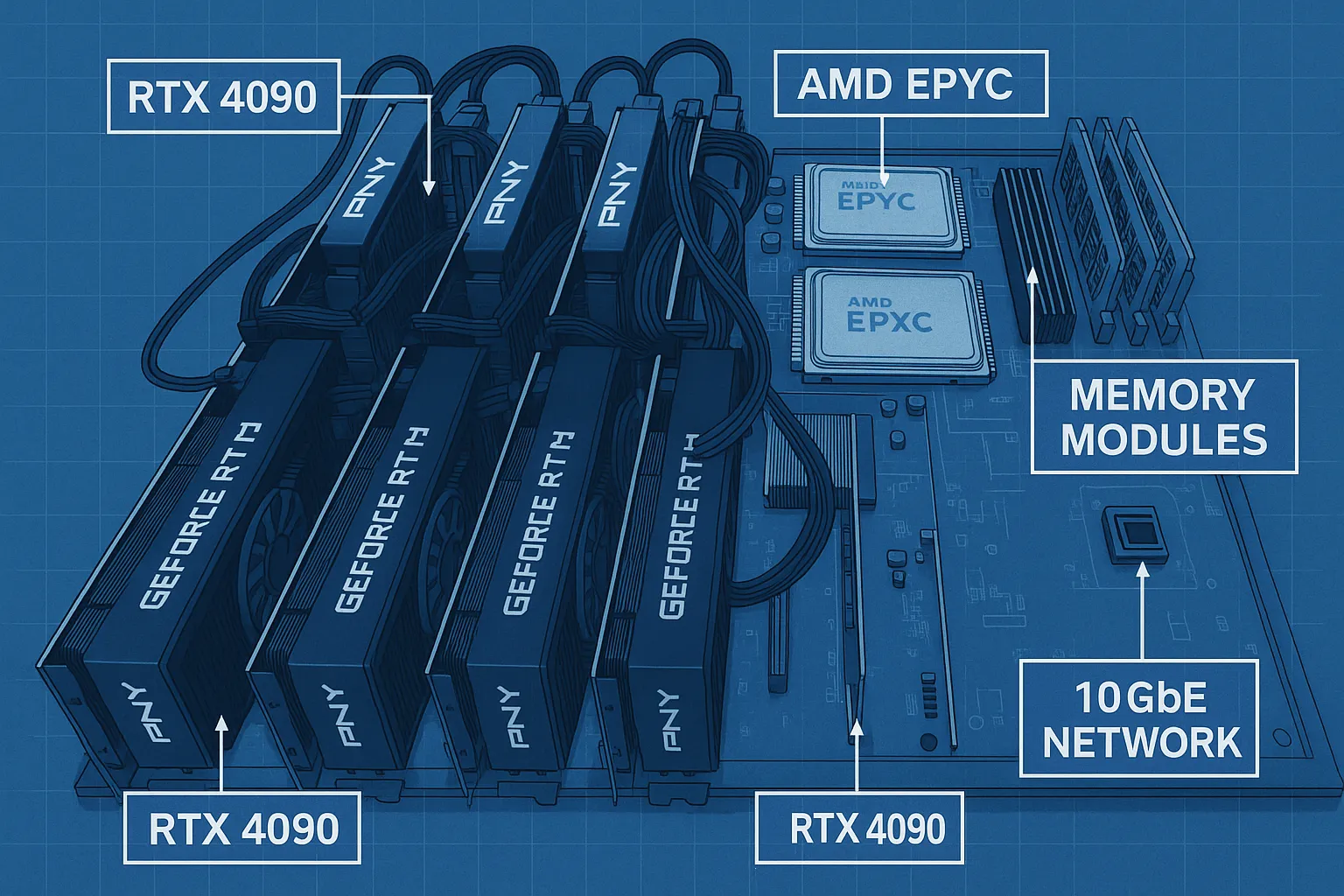

Arquitectura del servidor

El servidor se construyó sobre un chasis ASUS ESC8000A-E12P, seleccionado por su capacidad de albergar múltiples tarjetas y facilitar la personalización del cableado PCIe. A continuación, los componentes principales:

- GPU: 8× NVIDIA GeForce RTX 4090, cada una con 24 GB de VRAM y 16 384 CUDA cores, empleadas sin extensores ni retimers gracias a una configuración de placas PCIe independientes.

- CPU: 2× AMD EPYC 9254 (24 núcleos, 2.90 GHz, 128 MB caché), para ofrecer ancho de banda de memoria y cómputo de CPU acorde al rendimiento de las GPUs.

- Memoria RAM: 24× 16 GB DDR5 ECC RDIMM (384 GB totales), optimizados para cargas de trabajo de entrenamiento e inferencia pesada.

- Almacenamiento: 1.92 TB Micron 7450 PRO Series M.2 PCIe 4.0 NVMe SSD, con velocidades de lectura/escritura elevadas para acelerar el acceso a conjuntos de datos.

- Red: 2 puertos 10 GbE (controladoras X710-AT2), uno de ellos dedicado a un enlace de fibra monomodo a 10 Gb/s simétricos, asegurando transferencia rápida de datos sin cuellos de botella.

- Sistema operativo: Ubuntu Linux 22.04 LTS Server Edition (64-bit).

Diseño PCIe y distribución de potencia

Para aprovechar al máximo la capacidad de las RTX 4090, se emplearon dos placas PCIe 5.0 independientes (ASUS 90SC0M60-M0XBN0), cada una ocupando ocho carriles x16 completos. Cuatro GPUs se instalan en la placa inferior junto al motherboard, y otras cuatro en un marco externo de aluminio, construido con componentes GoBilda, que se monta sobre el chasis.

La alimentación eléctrica se gestiona mediante cables en “Y” para el conector ATX de 24 pines y los conectores de 6 pines, asegurando que cada GPU reciba el voltaje y la corriente adecuados sin comprometer la estabilidad del sistema.

Ventajas de una solución 100 % on-premises

- Privacidad y seguridad: Al mantener los datos y modelos dentro de la red local, se eliminan riesgos de exposición a terceros y se cumple con normativas de protección de datos.

- Costos predecibles: A diferencia de la facturación por uso en la nube, el costo de operación se limita a consumo eléctrico y mantenimiento de hardware.

- Baja latencia: La inferencia local evita la ida y vuelta de datos a data centers remotos, vital para aplicaciones en tiempo real.

- Flexibilidad: Se pueden aplicar parches, actualizaciones y configuraciones personalizadas sin restricciones de proveedores externos.

Casos de uso

Este tipo de infraestructura on-premises es ideal para:

- Investigación en IA: Experimentos con modelos de gran escala sin límite de cuota.

- Prototipos de chatbots y asistentes: Implementación de pipelines RAG (Retrieval-Augmented Generation) con datos alternativos.

- Procesamiento de imágenes y video: Entrenamiento y ejecución de modelos de difusión o detección en tiempo real.

- Aplicaciones empresariales sensibles: Análisis de datos médicos, financieros o de seguridad donde la confidencialidad es primordial.

¿Por qué construir un servidor GPU local?

En un entorno donde la mayoría de las soluciones de IA se apoyan en servicios en la nube, existe una creciente necesidad de ejecutar modelos localmente para evitar:

- Llamadas a APIs externas que pueden introducir latencia y costos variables.

- Filtrado de datos y posibles fugas de información, especialmente en industrias reguladas.

- Limitaciones de uso o throttling impuestos por proveedores de nube, que pueden afectar proyectos de investigación o entornos de prueba.

Optar por una infraestructura propia permite un aislamiento completo de los datos, garantiza privacidad y ofrece predictibilidad en la facturación, elementos clave para equipos de desarrollo y académicos que manejan información sensible.